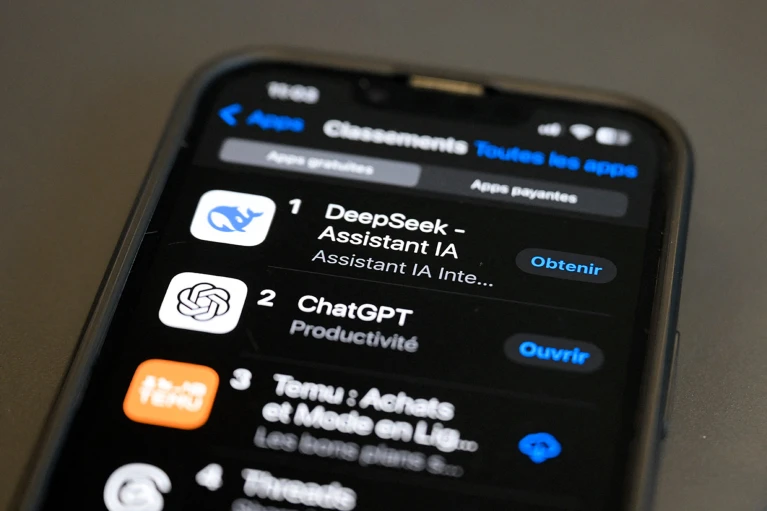

چین با ایجاد مدل هوش مصنوعی DeepSeek، جهان را شوکه کرد!

استارتآپ فناوری چینی DeepSeek با عرضه دو مدل زبانی بزرگ (LLMs) که عملکردی رقابتی با ابزارهای پیشرو توسعهیافته توسط غولهای فناوری آمریکایی دارند، اما با هزینه و قدرت محاسباتی بسیار کمتر ساخته شدهاند، دنیای فناوری را تحت تأثیر قرار داده است.

در ۲۰ ژانویه، این شرکت مستقر در هانگژو، مدل DeepSeek-R1 را منتشر کرد، یک مدل «استدلالی» نیمهمنبعباز که میتواند برخی مسائل علمی را با استانداردی مشابه o1، پیشرفتهترین مدل زبانی شرکت OpenAI، حل کند. این شرکت که در سان فرانسیسکو، کالیفرنیا مستقر است، اواخر سال گذشته این مدل را معرفی کرد. همچنین، اوایل این هفته، DeepSeek مدل دیگری به نام Janus-Pro-7B را راهاندازی کرد که میتواند تصاویر را از متن تولید کند، مشابه مدلهای DALL-E 3 شرکت OpenAI و Stable Diffusion شرکت Stability AI در لندن.

اگر عملکرد DeepSeek-R1 بسیاری از افراد خارج از چین را شگفتزده کرد، محققان داخل چین میگویند موفقیت این استارتآپ قابل انتظار بوده و با بلندپروازی دولت برای تبدیل شدن به یک رهبر جهانی در زمینه هوش مصنوعی (AI) همخوانی دارد.

یونجی چن، دانشمند کامپیوتر در مؤسسه فناوری محاسباتی آکادمی علوم چین در پکن، میگوید: «با توجه به سرمایهگذاری گسترده شرکتهای سرمایهگذاری خطرپذیر در توسعه مدلهای زبانی بزرگ و تعداد زیاد افراد دارای مدرک دکترا در علوم، فناوری، مهندسی و ریاضیات، از جمله هوش مصنوعی، ظهور شرکتی مانند DeepSeek در چین اجتنابناپذیر بود. اگر DeepSeek وجود نداشت، مدل زبانی بزرگ دیگری از چین وجود داشت که میتوانست کارهای بزرگی انجام دهد.»

در واقع، چنین شرکتهایی وجود دارند. در ۲۹ ژانویه، غول فناوری Alibaba پیشرفتهترین مدل زبانی خود تا به امروز، Qwen2.5-Max، را منتشر کرد که به گفته این شرکت، از مدل V3 شرکت DeepSeek که در دسامبر منتشر شد، عملکرد بهتری دارد. همچنین، هفته گذشته، شرکتهای Moonshot AI و ByteDance مدلهای استدلالی جدیدی به نامهای Kimi 1.5 و ۱.۵-pro را راهاندازی کردند که به ادعای این شرکتها، در برخی آزمونهای معیار، از مدل o1 عملکرد بهتری دارند.

اولویت دولت

در سال ۲۰۱۷، دولت چین اعلام کرد که قصد دارد این کشور تا سال ۲۰۳۰ به رهبر جهانی هوش مصنوعی تبدیل شود. این دولت صنعت را موظف کرد تا تا سال ۲۰۲۵ به پیشرفتهای عمدهای در هوش مصنوعی دست یابد، بهگونهای که «فناوریها و کاربردها به سطح پیشرو جهانی برسند.»

توسعه استعدادهای هوش مصنوعی به یک اولویت تبدیل شد. بر اساس گزارش مرکز امنیت و فناوریهای نوظهور (CSET) در دانشگاه جورجتاون در واشنگتن دیسی، تا سال ۲۰۲۲، وزارت آموزش چین به ۴۴۰ دانشگاه اجازه داده بود تا مدارک کارشناسی تخصصی در زمینه هوش مصنوعی ارائه دهند. در آن سال، چین تقریباً نیمی از محققان برتر هوش مصنوعی جهان را تأمین کرد، در حالی که سهم ایالات متحده تنها ۱۸٪ بود.

مارینا ژانگ، پژوهشگر سیاست علمی در دانشگاه فناوری سیدنی در استرالیا که بر نوآوری در چین تمرکز دارد، میگوید: «DeepSeek احتمالاً از سرمایهگذاری دولت در آموزش و توسعه استعدادهای هوش مصنوعی بهره برده است، که شامل بورسیههای تحصیلی متعدد، کمکهای تحقیقاتی و مشارکتهای بین دانشگاه و صنعت میشود.» به عنوان مثال، او اضافه میکند که ابتکارات دولتی مانند آزمایشگاه ملی مهندسی برای فناوری و کاربرد یادگیری عمیق، که توسط شرکت فناوری Baidu در پکن رهبری میشود، هزاران متخصص هوش مصنوعی را آموزش دادهاند.

نیروی کار جوان و متخصص

اگرچه یافتن آمار دقیق درباره نیروی کار DeepSeek دشوار است، اما لیانگ ونفنگ، بنیانگذار شرکت، به رسانههای چینی گفته است که این شرکت فارغالتحصیلان و دانشجویان دکترا از دانشگاههای برتر چین را استخدام کرده است. ژانگ میگوید: «برخی از اعضای تیم رهبری این شرکت کمتر از ۳۵ سال سن دارند و در دوران رشد خود شاهد ظهور چین به عنوان یک ابرقدرت فناوری بودهاند. آنها به شدت توسط انگیزه خوداتکایی در نوآوری برانگیخته شدهاند.»

ونفنگ، که ۳۹ ساله است، خود یک کارآفرین جوان است و در رشته علوم کامپیوتر از دانشگاه ژجیانگ، یک مؤسسه پیشرو در هانگژو، فارغالتحصیل شده است. او تقریباً یک دهه پیش صندوق سرمایهگذاری High-Flyer را تأسیس کرد و در سال ۲۰۲۳ شرکت DeepSeek را بنیان نهاد.

جیکوب فلدگویز، که در CSET بر استعدادهای هوش مصنوعی در چین مطالعه میکند، میگوید سیاستهای ملی که یک اکوسیستم توسعه مدل برای هوش مصنوعی را ترویج میکنند، به شرکتهایی مانند DeepSeek در جذب سرمایه و استعداد کمک کردهاند.

با این حال، فلدگویز میگوید با وجود افزایش دورههای هوش مصنوعی در دانشگاهها، مشخص نیست که چند دانشجو با مدرک تخصصی هوش مصنوعی فارغالتحصیل میشوند و آیا مهارتهایی که به آنها آموزش داده میشود، نیازهای شرکتها را برآورده میکند یا خیر. او میگوید: «شرکتهای هوش مصنوعی چین در سالهای اخیر抱怨 کردهاند که فارغالتحصیلان این برنامهها کیفیت مورد انتظار آنها را نداشتهاند»، که این موضوع باعث شده برخی شرکتها با دانشگاهها همکاری کنند.

کارایی تحت محدودیتها

DeepSeek و دیگر شرکتهای چینی در حال نشان دادن این هستند که چگونه میتوان با منابع محدود، مدلهای هوش مصنوعی کارآمد و قدرتمند ساخت. این رویکرد نه تنها هزینهها را کاهش میدهد، بلکه چین را به عنوان یک رهبر نوآور در عرصه فناوری جهانی تثبیت میکند.

ژانگ میگوید رهبری DeepSeek رویکردی متمایزاً چینی به نوآوری را تجسم میکند که بر کارایی تحت محدودیتها تأکید دارد. با این حال، این شرکت جزئیات خاصی درباره میزان سختافزاری که استفاده میکند، افشا نکرده است.

DeepSeek اعلام کرده است که برای آموزش مدل DeepSeek-V3، که در دسامبر منتشر شد و در آزمونهای معیار از مدل GPT-4o شرکت OpenAI که در ماه مه سال گذشته راهاندازی شد، عملکرد بهتری دارد، از حدود ۲٬۰۰۰ تراشه H800 ساختهشده توسط شرکت آمریکایی Nvidia استفاده کرده است. در مقابل، مدل پیشرفتهتر Llama 3.1 405B که در ژوئیه توسط شرکت Meta در منلو پارک، کالیفرنیا منتشر شد، به بیش از ۱۶٬۰۰۰ تراشه پیشرفتهتر H100 شرکت Nvidia متکی است. در یک پست سال ۲۰۲۲ در پلتفرم رسانه اجتماعی WeChat، شرکت High-Flyer اعلام کرد که ۱۰٬۰۰۰ تراشه قدیمیتر A100 شرکت Nvidia را در اختیار دارد که احتمالاً DeepSeek نیز به آنها دسترسی دارد. استفاده DeepSeek از تراشههای کمتوانتر احتمالاً باعث شده است که مدلهای آن با هزینه کمتری ساخته شوند. ونفنگ در ژوئیه ۲۰۲۴ به رسانههای چینی گفت: «مشکلی که با آن روبرو هستیم هرگز پول نبوده، بلکه ممنوعیت تراشههای پیشرفته است.»

DeepSeek از روشهای مختلفی برای افزایش کارایی مدلهای خود استفاده میکند. به عنوان مثال، این شرکت از یک معماری «مخلوط متخصصان» (mixture-of-experts) استفاده میکند، یک روش یادگیری ماشینی که مدلها را سریعتر از تکنیکهای معمولی و با پارامترهای کمتری آموزش میدهد. چانگ شو، دانشمند کامپیوتر در دانشگاه سیدنی، میگوید این روش به شرکت اجازه میدهد تا مدلها را با تراشههای کمتری آموزش دهد. همچنین، این شرکت از نسخهای نوآورانه از تکنیک دیگری به نام توجه نهفته چندسر (multi-head latent attention) استفاده میکند که به مدل اجازه میدهد دادههای بیشتری را با حافظه کمتری ذخیره کند.

این هفته، گزارشهای رسانهای حاکی از آن بود که OpenAI در حال بررسی ادعاهایی است که DeepSeek مدل خود را با استفاده از خروجیهای مدلهای OpenAI آموزش داده است. (OpenAI به دلیل نقض مالکیت فکری توسط سازمانهای خبری تحت پیگرد قانونی قرار دارد). DeepSeek هنوز به این ادعاها پاسخ نداده است. لوئیس تانستال، محقق در پلتفرم علم باز Hugging Face مستقر در برن، سوئیس، میگوید حتی اگر این ادعاها درست باشند، به هیچ وجه از دستاورد DeepSeek در ایجاد مدل R1 نمیکاهد. او میگوید پیشرفت این شرکت در استفاده از یک رویکرد یادگیری برای القای تواناییهای «استدلالی» به یک مدل زبانی بزرگ است، که آزمایشها آن را تکرار کردهاند. Hugging Face در حال رهبری یک پروژه برای تلاش در جهت بازسازی مدل R1 از ابتدا است. تانستال میگوید: «من انتظار داریم به سرعت متوجه شویم که آیا واقعاً به دادههای مصنوعی از OpenAI نیاز است یا خیر.»

یانبو وانگ، پژوهشگر سیاست علمی که بر نوآوری در دانشگاه هنگکنگ تمرکز دارد، میگوید دستاوردهای DeepSeek میتواند الگویی برای کشورهایی باشد که آرزوهای بزرگی در زمینه هوش مصنوعی دارند اما فاقد منابع مالی و سختافزاری برای آموزش مدلهای زبانی بزرگ با استفاده از رویکرد استاندارد سیلیکونولی هستند. او میگوید: «این میتواند منجر به ایجاد ارتش بزرگی از مدلهای جدید شود.»